Introducción al Aprendizaje Automático

El aprendizaje automático, una rama crucial de la inteligencia artificial, se refiere a la capacidad de las máquinas para aprender y mejorar a partir de datos sin necesidad de una programación explícita. Este concepto revolucionario está transformando industrias enteras, permitiendo el análisis de grandes volúmenes de datos, el reconocimiento de patrones complejos y la predicción de resultados futuros con una precisión sin precedentes.

En su esencia, el aprendizaje automático se basa en el desarrollo de algoritmos que pueden identificar patrones en datos históricos y aplicar ese conocimiento para hacer predicciones o tomar decisiones basadas en nuevos datos. Estos algoritmos pueden ser supervisados, no supervisados o basados en el refuerzo, cada uno con sus propias ventajas y aplicaciones específicas.

La importancia del aprendizaje automático en la era de los datos no puede ser subestimada. Con el crecimiento exponencial de la cantidad de datos generados diariamente, se hace imperativo contar con herramientas capaces de analizar y extraer información valiosa de estos datos. Empresas en sectores como la salud, las finanzas, el comercio y la tecnología están utilizando el aprendizaje automático para mejorar sus operaciones, optimizar procesos y ofrecer productos y servicios más personalizados y eficientes.

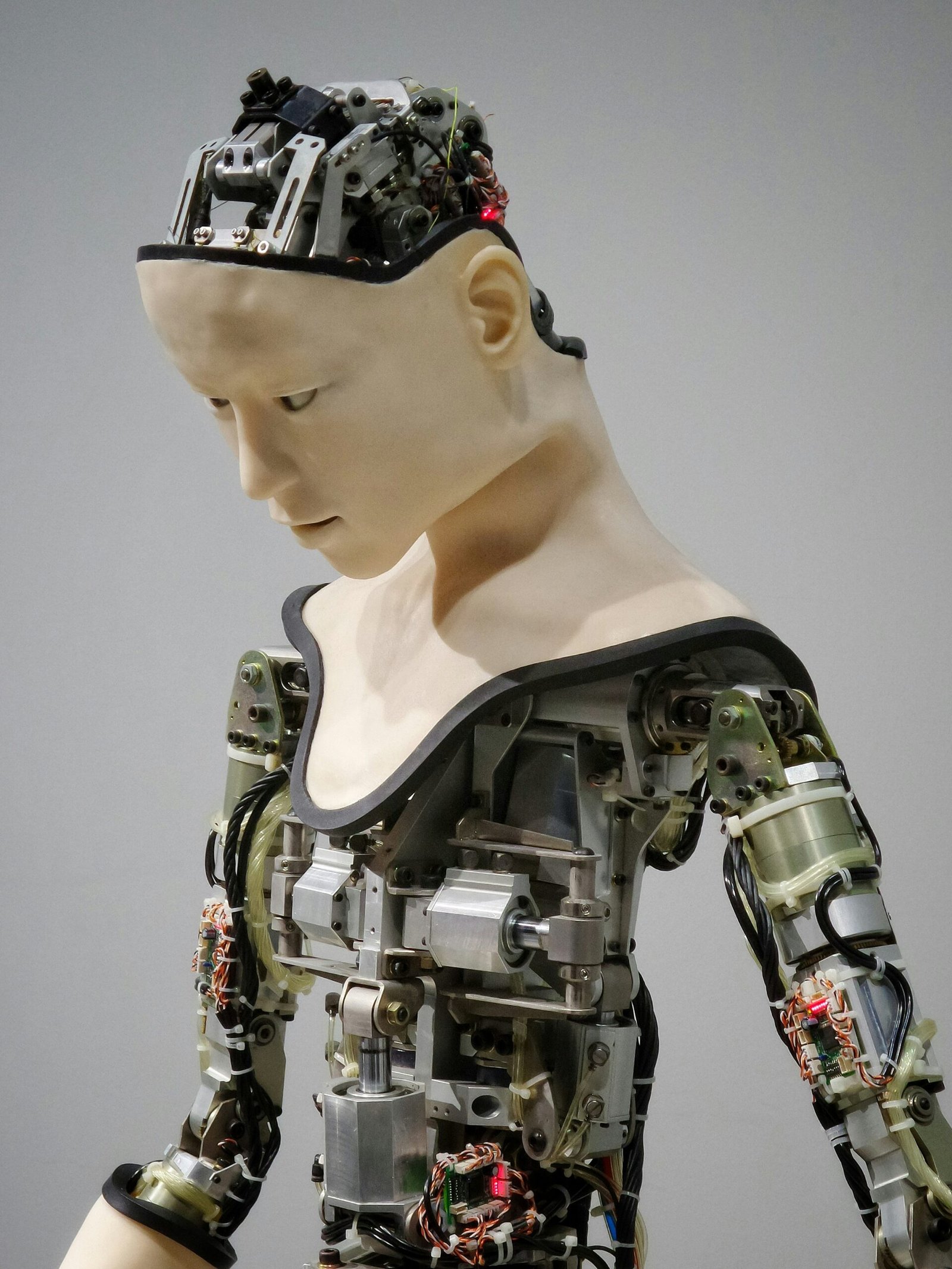

Además, el aprendizaje automático está impulsando avances en áreas como la visión por computadora, el procesamiento del lenguaje natural y la robótica. Estas aplicaciones están permitiendo la creación de sistemas que pueden interactuar de manera más efectiva con los humanos y el entorno, mejorando la calidad de vida y abriendo nuevas fronteras en la ciencia y la tecnología.

En resumen, el aprendizaje automático es una disciplina fundamental en el campo de la inteligencia artificial. Su capacidad para transformar datos en conocimiento y acciones significativas está marcando el comienzo de una nueva era de innovación y eficiencia. A medida que continuamos avanzando en esta era digital, el aprendizaje automático seguirá siendo una herramienta indispensable para enfrentar los desafíos del futuro.

Principios Básicos del Aprendizaje Automático

El aprendizaje automático, una subdisciplina de la inteligencia artificial, se centra en la creación y el uso de algoritmos que permiten a las máquinas aprender de los datos y mejorar su rendimiento con el tiempo. Los sistemas de aprendizaje automático identifican patrones en grandes volúmenes de datos y utilizan estos patrones para hacer predicciones o tomar decisiones con una mínima intervención humana.

El primer paso en el proceso de aprendizaje automático es la recopilación de datos. Estos datos, a menudo denominados “conjuntos de datos de entrenamiento”, son esenciales para entrenar los modelos de aprendizaje. Los conjuntos de datos de entrenamiento contienen ejemplos representativos del problema que el modelo intenta resolver, y deben ser lo suficientemente diversos y completos para que el modelo pueda aprender de manera efectiva.

Una vez que se han recopilado los datos, se procede al entrenamiento del modelo. Durante esta fase, el modelo se ajusta iterativamente utilizando algoritmos específicos que optimizan su capacidad para predecir o clasificar nuevos datos. Estos algoritmos varían en complejidad, desde métodos sencillos como la regresión lineal hasta técnicas más avanzadas como las redes neuronales profundas. El objetivo es minimizar el error en las predicciones realizadas por el modelo.

El ajuste de los modelos es una etapa crítica para mejorar su precisión. Esto implica afinar los parámetros del modelo y, a veces, modificar la estructura del algoritmo utilizado. Técnicas como la validación cruzada y el ajuste de hiperparámetros son comunes en esta fase. Estas técnicas ayudan a garantizar que el modelo no solo funcione bien con los datos de entrenamiento, sino que también generalice adecuadamente a datos nuevos y no vistos.

En resumen, los principios básicos del aprendizaje automático incluyen la recopilación y preparación de datos, el entrenamiento del modelo con algoritmos apropiados y el ajuste continuo para mejorar su precisión y rendimiento. Estos principios permiten a las máquinas aprender y tomar decisiones informadas de manera autónoma, lo que abre un mundo de posibilidades en diversas aplicaciones.

Tipos de Aprendizaje Automático

El aprendizaje automático se clasifica en varios tipos, cada uno con sus propias características y aplicaciones específicas. Los principales tipos de aprendizaje automático son: supervisado, no supervisado, semi-supervisado y por refuerzo.

Aprendizaje Supervisado

El aprendizaje supervisado se basa en un conjunto de datos de entrenamiento etiquetado. Estos datos contienen pares de entrada y salida, lo que permite al modelo aprender a mapear entradas a salidas correctas. Un ejemplo práctico es la clasificación de correos electrónicos como spam o no spam. Aquí, el modelo se entrena con un conjunto de correos previamente clasificados y aprende a identificar patrones que indican si un correo es spam.

Aprendizaje No Supervisado

El aprendizaje no supervisado, a diferencia del supervisado, no utiliza datos etiquetados. En su lugar, busca patrones y estructuras ocultas en los datos. Un ejemplo típico es el agrupamiento de clientes en segmentos de mercado. Mediante técnicas como el clustering, el modelo puede identificar grupos de clientes con comportamientos similares, lo que es útil para estrategias de marketing personalizadas.

Aprendizaje Semi-Supervisado

El aprendizaje semi-supervisado combina aspectos del aprendizaje supervisado y no supervisado. Utiliza un pequeño conjunto de datos etiquetados junto con un gran conjunto de datos no etiquetados. Este enfoque es útil cuando la obtención de datos etiquetados es costosa o difícil. Por ejemplo, en el reconocimiento de imágenes, se pueden utilizar unas pocas imágenes etiquetadas para guiar el modelo a clasificar muchas más imágenes sin etiquetas.

Aprendizaje por Refuerzo

El aprendizaje por refuerzo se centra en la toma de decisiones secuenciales. Un agente aprende a actuar en un entorno mediante ensayo y error, recibiendo recompensas o castigos en función de sus acciones. Un ejemplo clásico es el entrenamiento de un robot para navegar por un laberinto. El agente recibe recompensas por moverse en la dirección correcta y penalizaciones por tomar caminos incorrectos, lo que le ayuda a aprender la mejor estrategia para alcanzar su objetivo.

Algoritmos de Aprendizaje Supervisado

El aprendizaje supervisado es una técnica fundamental en el ámbito del aprendizaje automático, donde los algoritmos se entrenan con datos etiquetados para predecir resultados sobre nuevos datos. Entre los algoritmos más comunes en este campo se encuentran la regresión lineal, la regresión logística, los árboles de decisión, las máquinas de soporte vectorial (SVM) y las redes neuronales. Cada uno de estos algoritmos tiene características y aplicaciones particulares que los hacen especialmente útiles en diferentes contextos.

Regresión Lineal: Este algoritmo se utiliza principalmente para problemas de predicción de valores continuos. Su funcionamiento se basa en encontrar la línea recta que mejor se ajusta a los datos de entrada, minimizando la diferencia entre los valores predichos y los reales. Es ampliamente utilizado en áreas como la economía y la ingeniería.

Regresión Logística: A diferencia de la regresión lineal, la regresión logística se emplea para problemas de clasificación binaria. En lugar de predecir un valor continuo, este algoritmo estima la probabilidad de que una instancia pertenezca a una de dos clases posibles. Es muy útil en aplicaciones como la detección de fraudes y el diagnóstico médico.

Árboles de Decisión: Los árboles de decisión son modelos de predicción que dividen iterativamente los datos en subconjuntos más pequeños basados en características específicas. Este enfoque jerárquico facilita la interpretación de los resultados y es eficaz en tareas de clasificación y regresión. Su simplicidad y capacidad de manejo de datos no lineales los hacen populares en diversas áreas.

Máquinas de Soporte Vectorial (SVM): Las SVM son algoritmos potentes para problemas de clasificación y regresión. Funcionan mediante la identificación de un hiperplano que separa las clases en el espacio de características de manera óptima. Las SVM son especialmente útiles en problemas de alta dimensionalidad y en situaciones donde las clases son claramente separables.

Redes Neuronales: Inspiradas en el funcionamiento del cerebro humano, las redes neuronales son modelos complejos que consisten en capas de neuronas interconectadas. Son extremadamente versátiles y pueden manejar grandes volúmenes de datos y tareas complejas como el reconocimiento de imágenes y el procesamiento del lenguaje natural. Sin embargo, requieren una cantidad significativa de datos y recursos computacionales para su entrenamiento.

En conjunto, estos algoritmos de aprendizaje supervisado forman la base sobre la cual se construyen muchas de las aplicaciones modernas de aprendizaje automático, demostrando su relevancia y utilidad en una amplia gama de contextos.

Algoritmos de Aprendizaje No Supervisado

El aprendizaje no supervisado se distingue por su capacidad para identificar patrones y relaciones en los datos sin la necesidad de etiquetas predefinidas. Entre los algoritmos más utilizados en este enfoque se encuentran el k-means, el Análisis de Componentes Principales (PCA), el clustering jerárquico y el algoritmo Apriori.

El algoritmo k-means es fundamental en el aprendizaje no supervisado. Este algoritmo agrupa los datos en k clústeres o grupos basándose en la similitud de sus características. Inicialmente, el algoritmo selecciona k puntos como centroides y luego asigna cada punto de datos al clúster más cercano, ajustando los centroides iterativamente hasta que los clústeres se estabilizan. Este método es particularmente útil en la segmentación de clientes y la identificación de patrones en grandes conjuntos de datos.

El Análisis de Componentes Principales (PCA) es otro método vital que reduce la dimensionalidad de los datos. PCA transforma las variables originales en un conjunto de nuevas variables no correlacionadas, llamadas componentes principales, que capturan la mayor parte de la variabilidad en los datos. Esto facilita la visualización y el análisis de datos complejos, mejorando la eficiencia de otros algoritmos de aprendizaje automático.

El clustering jerárquico organiza los datos en una estructura de árbol o dendrograma. Este algoritmo no requiere un número predefinido de clústeres. En su lugar, agrupa los datos en niveles jerárquicos, permitiendo a los usuarios explorar la estructura del clúster a diferentes niveles de granularidad. Es ideal para aplicaciones donde las relaciones jerárquicas son importantes, como la clasificación de documentos y la agrupación de genes en biología.

El algoritmo Apriori es prominente en la minería de datos para descubrir patrones frecuentes y reglas de asociación. Se utiliza comúnmente en la análisis de cestas de compra, donde identifica conjuntos de artículos que se compran juntos con frecuencia. Este algoritmo ayuda a las empresas a tomar decisiones informadas sobre la disposición de productos y estrategias de marketing.

En resumen, los algoritmos de aprendizaje no supervisado ofrecen herramientas poderosas para descubrir estructuras y relaciones ocultas en datos sin etiquetar, mejorando la capacidad de las organizaciones para tomar decisiones basadas en datos.

Herramientas y Bibliotecas Populares de Machine Learning

El aprendizaje automático ha ganado una notable popularidad en los últimos años, en gran parte gracias a la disponibilidad de potentes herramientas y bibliotecas. Estas herramientas facilitan el desarrollo, implementación y escalado de modelos de machine learning. A continuación, se presentan algunas de las más destacadas y ampliamente utilizadas en la industria y la academia.

TensorFlow: Desarrollada por Google, TensorFlow es una biblioteca de código abierto que se utiliza tanto para investigaciones como para aplicaciones comerciales. Su flexibilidad y capacidad para manejar grandes volúmenes de datos la convierten en una opción ideal para proyectos de deep learning. TensorFlow también ofrece TensorFlow Lite para dispositivos móviles y TensorFlow Extended (TFX) para producción a gran escala.

PyTorch: Creada por Facebook, PyTorch es otra biblioteca de código abierto que ha ganado popularidad por su facilidad de uso y su dinámica de computación gráfica. PyTorch es muy apreciada en la comunidad de investigación por su capacidad de crear modelos de aprendizaje profundo de manera intuitiva y eficiente. Además, cuenta con una integración sólida con Python, lo que facilita su uso para desarrolladores familiarizados con este lenguaje.

scikit-learn: Esta biblioteca, basada en Python, es una de las más utilizadas para aprendizaje automático tradicional. scikit-learn proporciona herramientas simples y eficientes para la minería de datos y el análisis de datos, y es particularmente adecuada para proyectos que no requieren la complejidad del deep learning. Su amplia gama de algoritmos y facilidad de integración con otras bibliotecas de Python la hacen indispensable para muchos científicos de datos.

Keras: Aunque Keras es ahora parte de TensorFlow, originalmente era una biblioteca independiente. Keras es conocida por su simplicidad y facilidad de uso, lo que permite a los desarrolladores construir y experimentar con modelos de deep learning rápidamente. Es una excelente opción para principiantes y para aquellos que prefieren una interfaz de alto nivel sin sacrificar la flexibilidad.

Apache Spark MLlib: Para aquellos que necesitan escalar modelos de machine learning en grandes volúmenes de datos distribuidos, Apache Spark MLlib es una opción robusta. Esta biblioteca, parte de Apache Spark, ofrece una variedad de algoritmos de machine learning y herramientas para la implementación de modelos en clústeres de computación distribuida. Es ideal para empresas que manejan grandes cantidades de datos y requieren soluciones escalables.

En resumen, la elección de la herramienta o biblioteca de machine learning adecuada depende de las necesidades específicas del proyecto, la escala de los datos y la experiencia del equipo de desarrollo. Cada una de estas herramientas ofrece características únicas que pueden ser aprovechadas para optimizar el proceso de desarrollo y despliegue de modelos de aprendizaje automático.

Aplicaciones del Aprendizaje Automático en la Industria

El aprendizaje automático ha transformado diversas industrias al habilitar análisis de datos más profundos y la automatización de procesos complejos. En la industria de la salud, por ejemplo, se utiliza para el diagnóstico médico mediante el análisis de imágenes y datos de pacientes. Algoritmos avanzados pueden detectar enfermedades como el cáncer en sus etapas tempranas con mayor precisión que los métodos tradicionales. Además, el aprendizaje automático facilita la personalización de tratamientos, mejorando así la efectividad y reduciendo los efectos secundarios.

En el sector financiero, el aprendizaje automático se aplica en la detección de fraudes y la gestión de riesgos. Los algoritmos pueden analizar miles de transacciones en tiempo real, identificando patrones sospechosos y alertando a los responsables de seguridad. Asimismo, se utiliza en la toma de decisiones de inversión, donde los modelos predictivos analizan grandes volúmenes de datos de mercado para identificar oportunidades de inversión y tendencias emergentes.

El comercio minorista también se ha beneficiado enormemente del aprendizaje automático. Las empresas utilizan algoritmos para personalizar la experiencia del cliente, recomendando productos basados en el comportamiento de compra y las preferencias individuales. Además, la optimización de la cadena de suministro y la gestión de inventarios se han mejorado significativamente mediante el uso de modelos predictivos que anticipan la demanda de productos.

En el ámbito tecnológico, la inteligencia artificial y el aprendizaje automático son fundamentales para el desarrollo de asistentes virtuales y sistemas de reconocimiento de voz. Empresas como Google y Amazon emplean estas tecnologías para mejorar la interacción con sus usuarios, proporcionando respuestas más precisas y relevantes. Además, en el campo de la ciberseguridad, el aprendizaje automático se utiliza para identificar amenazas y vulnerabilidades, protegiendo tanto a individuos como a organizaciones de posibles ataques.

Sin embargo, el uso del aprendizaje automático no está exento de desafíos. La calidad de los datos y los sesgos en los algoritmos pueden afectar los resultados, y las consideraciones éticas, como la privacidad y el uso justo de los datos, son cruciales. Es fundamental que las empresas implementen políticas robustas para abordar estos desafíos y garantizar un uso responsable de la tecnología.

Conclusión y Futuro del Aprendizaje Automático

En conclusión, el aprendizaje automático ha transformado diversos sectores gracias a su capacidad para analizar grandes volúmenes de datos y extraer patrones relevantes. A lo largo de este artículo, hemos explorado conceptos fundamentales, desde el entendimiento de los tipos de aprendizaje (supervisado, no supervisado y por refuerzo) hasta la implementación de algoritmos clave como regresión, árboles de decisión y redes neuronales.

La importancia de una comprensión clara de estos conceptos no puede ser subestimada. Dominar los fundamentos del aprendizaje automático permite a desarrolladores y científicos de datos no solo construir modelos más precisos y eficientes, sino también interpretar los resultados y tomar decisiones informadas. Además, el conocimiento de las herramientas disponibles, como TensorFlow, PyTorch y scikit-learn, es esencial para aprovechar al máximo el potencial del machine learning. Estas bibliotecas proporcionan un marco robusto y flexible que facilita la creación de soluciones innovadoras.

El futuro del aprendizaje automático promete ser aún más emocionante. Con el avance continuo en hardware, como los procesadores gráficos (GPUs) y las unidades de procesamiento tensorial (TPUs), el entrenamiento de modelos complejos se está volviendo más rápido y accesible. Las aplicaciones emergentes en áreas como la salud, la energía y el transporte destacan el impacto transformador del aprendizaje automático. Por ejemplo, en la medicina, los algoritmos de machine learning están ayudando a diagnosticar enfermedades con una precisión sin precedentes, mientras que en el sector energético, están optimizando el uso de recursos naturales.

Asimismo, la inteligencia artificial explicable (XAI) está ganando terreno, buscando hacer los modelos de aprendizaje automático más transparentes y comprensibles para los humanos. Esto es crítico para la adopción generalizada de estas tecnologías, ya que aumenta la confianza y facilita la integración en procesos críticos. En resumen, el aprendizaje automático no solo está revolucionando la tecnología, sino que también está redefiniendo la manera en que interactuamos con el mundo, ofreciendo oportunidades ilimitadas para el desarrollo y la innovación.